在AI写作工具广泛普及的今天,大量站点通过AI辅助产出SEO内容。然而,在提升效率的同时,一种隐蔽的风险正在蔓延:**内容段落在多个页面中重复出现,导致搜索引擎判定为“内容重叠”,从而触发降权机制。**这不仅影响排名,还可能使页面失去收录资格。

尤其在规模化部署AI生成内容的站群、内容矩阵、电商商品页、行业知识库中,**段落级内容复用的“非恶意重复”**成为排名波动的重要诱因。本文将系统解析:

- AI内容重复的核心机制

- “内容重叠”如何被搜索引擎识别

- 重复段落的实际SEO影响

- 如何构建“重复性规避”机制

- 内容重叠惩罚的恢复路径与应对策略

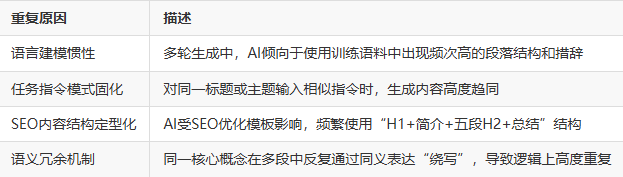

一、AI生成内容的“句群依赖性”:重复性的生成结构原因

AI写作模型(如GPT系列、Claude、Gemini等)生成文本的底层机制具有一定“模板化倾向”:

示例场景:

在10篇关于“如何提升页面加载速度”的AI写作内容中,以下段落可能被几乎一字不差地复制:

“使用CDN是提升全球访问速度的重要手段,它通过就近节点缓存页面资源,减少用户与服务器之间的物理距离。”

这类内容虽然语义正确,却可能在搜索引擎的“重复片段识别算法”中被归类为段落级复写,尤其当出现于多个URL中时。

二、Google如何识别“内容重叠”:从段落去重到语义聚类

谷歌在“内容去重”(Deduplication)上的策略并非仅基于关键词重复,而是更进一步地发展出了语义相似性识别 + 片段聚类 + 来源权重优先机制,主要包括:

1. Shingling算法 + Hash编码

- 将文本内容划分为固定长度(如5-10词)的“句法碎片”(Shingle)

- 通过哈希方式快速匹配不同页面间的Shingle重复度

- 当重复度超过阈值(如40%),则标记为“部分重复页面”

2. 语义聚类与嵌入匹配(Semantic Embedding)

- 使用BERT或MUM等模型将段落转换为向量嵌入(embedding)

- 比较多个页面在语义向量空间中的相似度

- 即便措辞不同,只要意图一致、内容核心类似,也会被聚类归一

3. 页面片段优先机制(Content Canonicalization)

- 对比多个重复段落所在页面的权重(如内链支持、外链引用、历史收录)

- 仅保留权重高的一页,其余页面即使收录,也不显示在SERP中(soft deindex)

**关键词“内容重叠”频繁出现时,Google会调用多层去重模型进行判断,不是简单的关键词匹配,而是基于上下文意图和页面重要度。”

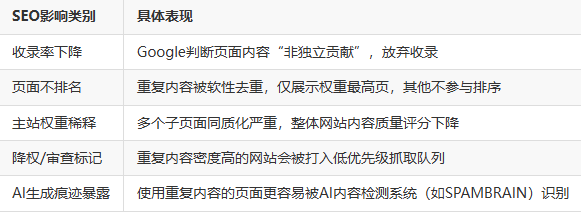

三、AI内容重复会带来的SEO后果

四、重复性规避策略:如何打造“语义上唯一”的AI内容?

1. 构建主题语义树,拆分角度写作

通过将主题拆分为多个“子维度+特定场景+应用对象”组合,保证每一篇文章角度唯一。如下表:

2. 使用AI内容去重检测器(如 Originality.ai)

- 针对AI批量生成内容,使用检测器标记出重复片段

- 实现段落级改写而非仅词句替换

- 特别注意H2/H3下的首段内容,极易被判为重复

3. 手工加入“经验型细节”与“第一性解释”

- 如行业经验、用户反馈引述、工具使用过程截图等

- 融入“作者亲身经历”类语句,提升内容独特性

示例:“我们在使用Cloudflare CDN进行A/B测试时发现,资源压缩比远比节点优化影响更大。”

这类句式,AI难以凭空生成,能有效打破重复判断。

五、实战案例:内容矩阵中AI段落重复的检测与修复

以某SaaS公司知识库为例,原始内容如下:

- 共发布120篇教程文章

- 使用AI对同一文档模板填充不同产品功能

- 出现收录量下降70%、关键词排名消失的情况

检测结果

- 多达63篇页面中的“操作步骤段落”完全一致

- Google仅收录15篇,其他皆被soft deindex处理

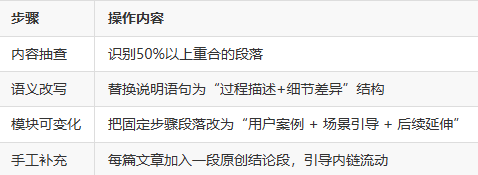

修复策略

修复后1个月内,网站收录恢复至原水平,且AI判定权重标签显著改善。

六、如何应对内容重叠惩罚与恢复页面权重?

一旦被谷歌识别为“内容重叠页面”,恢复路径需分步骤实施:

Step 1:日志分析 + GSC覆盖报告核查

- 查看是否为“已抓取 - 尚未收录”

- 确认是否页面质量低或内容重复

Step 2:调整重复页面的内容与结构

- 用自定义H2标题替代通用表达

- 内容中加入“用户语料 + 外部引用 + 原创数据表格”

Step 3:使用Canonical或Noindex区分主次

- 对无法改写的重复页面加

rel=canonical - 或主动使用

meta robots noindex标记

Step 4:重建内容内链与语义连贯性

- 通过内链指向主内容页,转移权重

- 使用FAQ Schema或HowTo结构化数据丰富页面特征

七、结语:AI内容不是“多发即赢”,而是“结构差异+语义新意”

在Google越来越强调“内容原创性与用户贡献度”的时代,AI写作的最大误区就是陷入模板化结构+语义复用陷阱。SEO优化的本质是“差异化输出信号”,而非“语句数量叠加”。

“内容重叠”并非指完全抄袭,而是一种算法层面对“重复表达”的严密管控机制,无论你是否人工生成,只要无法给出“新的信息增量”,就可能被边缘化。

未来AI内容的出路,不在生成,而在于“协同+润色+结构干预”。否则,生成100篇重复段落的内容,不如发布1篇有深度的差异化文章。

霓优网络科技中心是一家专注于网站搜索引擎优化(SEO)的数字营销服务提供商,致力于帮助企业提升网站在搜索引擎中的排名与收录效果。我们提供全方位的SEO优化服务,包括关键词策略优化、内容质量提升、技术SEO调整及企业数字营销支持,助力客户在竞争激烈的网络环境中获得更高的曝光度和精准流量。