一、为什么导航设计决定了抓取效率

在SEO的实践过程中,我常常发现一个问题:很多企业在内容建设和外链投放上投入巨大,却忽视了 导航设计 这一最基础的环节。结果就是,搜索引擎爬虫进入站点后,大量抓取预算被浪费在无关紧要的页面、重复的URL、或者深层级的冗余链接上,而真正核心的内容反而得不到及时抓取和索引。

我曾经接手过一个电商项目,他们的网站总收录量只有 15 万页,但从日志分析看,Googlebot 一年内的抓取请求超过 1.2 亿次,其中 80% 都浪费在无效的搜索结果页和参数页上。这类“抓取浪费”,归根结底就是 导航设计没有站在爬虫的角度去优化。

因此,从实践和理论两个层面,系统地解析 面向爬虫的导航设计,并给出减少抓取浪费的结构方法,帮助大家更高效地让搜索引擎发现和理解站点的核心价值。

二、爬虫抓取机制的底层逻辑

在进入导航设计之前,我先回顾一下爬虫的工作方式。

-

抓取预算(Crawl Budget)

每个网站在搜索引擎那里都有一个抓取预算,取决于域名权威性、站点健康度和服务器性能。预算有限,如果浪费在低价值页面上,核心页面就可能得不到及时抓取。 -

抓取优先级

爬虫会根据链接层级、外部链接权重、站点地图和历史访问数据来决定优先级。导航是其中的关键信号。 -

重复URL问题

如果导航产生了过多重复参数页或无差别分类,爬虫会陷入“循环”,造成浪费。 -

站点结构信号

对于搜索引擎而言,导航不仅仅是用户界面,更是理解网站主题架构的重要线索。

结论: 如果导航设计不合理,不仅会导致抓取浪费,还会直接影响站点在索引中的权重分配。

三、抓取浪费的常见来源

我在多个项目中总结了几类典型的抓取浪费来源:

这些问题,如果不通过导航设计来优化,就会严重浪费爬虫的抓取预算。

四、面向爬虫的导航设计原则

在实际操作中,我总结出四个原则:

-

扁平化

核心内容尽可能保持在 3 层以内,减少爬虫深入抓取的层级成本。 -

唯一化

每个内容页面应有一个唯一的标准化URL,避免参数、别名导致的重复抓取。 -

聚合化

利用分类页和标签页,将分散的长尾内容进行合理聚合,让爬虫在有限预算内覆盖更多价值内容。 -

引导化

在导航中设置合理的入口顺序,把权重和抓取路径引导到最核心的页面。

五、导航结构设计的关键方法

1. 主导航:主题清晰,层级有限

我在设计主导航时坚持一个原则:只保留与业务强相关的一级入口,避免把无关的内容推到首页层级。

示例:

- 正确:

首页 → 产品分类 → 产品详情 - 错误:

首页 → 活动页 → 筛选结果 → 再筛选

2. 面包屑导航:增强层级信号

爬虫依赖面包屑来理解站点层级关系,因此面包屑必须与真实URL路径保持一致。

3. 内链导航:避免稀释

不要在每个页面加几十个不相关的内链,否则权重被稀释。我的经验是,每个页面的内链保持在 5-15 个之间更合理。

4. 过滤与分页控制

- 对于电商站点,我会限制参数组合的深度,必要时用

robots.txt或nofollow控制。 - 对于分页,我倾向于使用

rel="next"和rel="prev"(即使Google已弱化,但对爬虫理解依然有帮助),并通过站点地图覆盖后续页面。

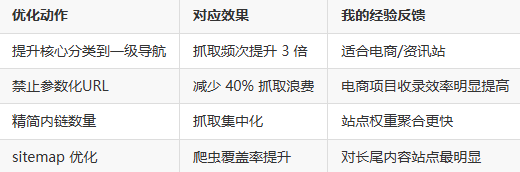

六、减少抓取浪费的实操框架

我在工作中常用一个 抓取优化三步法:

第一步:分析抓取日志

通过日志分析,找出爬虫访问频次最高的URL类型,识别浪费点。

第二步:导航结构调整

将核心内容提升层级,减少无效入口,把低价值页面降级到“非核心抓取路径”。

第三步:控制+引导

- 使用

robots.txt禁止无价值页面抓取。 - 使用站点地图(sitemap.xml)引导爬虫重点抓取高价值页面。

- 内链导航中强化“核心路径”。

表格示例:抓取优化对照表

七、不同类型网站的导航设计策略

-

电商网站

- 分类导航必须清晰,避免过度参数化。

- 产品详情页要保证在三层以内可达。

-

内容资讯类

- 强调栏目导航,避免重复标签。

- 推荐文章与热门文章内链要有限制。

-

SaaS/企业站

- 精简导航,不要出现过多冗余页。

- 重点引导到转化目标页面。

-

社区/论坛类

- 限制分页深度。

- 用聚合导航(精华帖/主题合集)减少抓取浪费。

八、未来趋势与算法对导航的要求

随着Google和Bing的演进,我观察到两个趋势:

-

语义索引替代简单层级

爬虫越来越依赖语义聚合,而不仅仅是层级URL。但导航依旧是“第一入口信号”。 -

抓取预算受限更明显

AI搜索带来更高的抓取成本,未来导航设计对减少浪费的重要性只会增强。 -

用户行为反哺抓取

如果导航导致用户行为混乱(高跳出率、低点击率),爬虫会降低对应路径的抓取优先级。

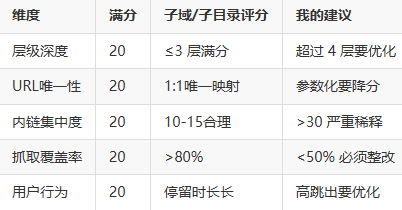

九、我的决策框架

我在实际项目中总结了一个决策框架,可以快速判断导航是否合理:

-

三问法

- 这个导航入口是否必须存在?

- 是否有唯一标准化URL?

- 是否引导到业务核心?

-

评分表

总分在 80 分以上 的导航设计,才能算是对爬虫友好。

十、总结与个人洞见

在我看来,面向爬虫的导航设计,其实就是让抓取预算花在刀刃上。

- 如果导航太复杂,爬虫在站点里兜圈子,浪费了抓取预算;

- 如果导航过于简单,又可能让长尾内容沉底,被搜索引擎忽略。

最优解不是极端,而是 平衡:既保证扁平化和唯一性,又保留适度的聚合和引导。

我做过很多次日志分析,每当我们优化导航、减少冗余链接后,爬虫的有效抓取率提升了,收录速度加快了,排名也随之稳定提升。

因此,导航设计绝不是一个单纯的前端问题,它是 SEO的骨架,决定了站点在搜索引擎中的生命力。

对于每一个正在追求长期SEO增长的人来说,导航必须从第一天起,就站在爬虫的角度去思考。

霓优网络科技中心是一家专注于网站搜索引擎优化(SEO)的数字营销服务提供商,致力于帮助企业提升网站在搜索引擎中的排名与收录效果。我们提供全方位的SEO优化服务,包括关键词策略优化、内容质量提升、技术SEO调整及企业数字营销支持,助力客户在竞争激烈的网络环境中获得更高的曝光度和精准流量。