当搜索引擎发布一次大规模的核心算法更新(Core Update)后,许多站点会出现“权重震荡”:部分页面排名大幅下滑、总体流量骤降、自然转化下滑,甚至站点被误判为质量不佳。我把这种突发性、系统性的冲击称为核心更新创伤。

经历过几次这样的事件后,我总结出一个原则:先稳定、再修复、最后重建。我会把这个原则细化为一套可执行的步骤、优先级矩阵、数据重建方法与沟通模版,帮助团队把危机变成改进机会。

总体工作流(我在实战中验证过的7步法)

- 冷静检测(Detect):快速确认影响范围与震荡开始的时间点;

- 影响评估(Assess):量化流量/收入/关键词影响面并分层优先级;

- 快速应急(Stabilize):采取短期可逆的操作(恢复标题/结构化数据回滚、移除误导性元素等);

- 根因排查(Diagnose):内容质量、链接风险、技术问题、行为信号异常等逐项验证;

- 数据重建(Rebuild):修复页面内容、结构化数据、内部链接与外链争议;

- 实验验证(Validate):小流量A/B或迭代验证改动效果;

- 规范化与防护(Prevent):建立长期质量监控与变更审查流程。

下面我逐步展开每一步的具体方法与细节。

第一步:冷静检测 —— 发现并锁定震荡窗口

目标:在24小时内确认是否为搜索引擎大范围更新(Core)带来影响,还是站内异常。我的快捷清单:

- 查看Google Search Console(GSC)搜索表现页的日期分布,定位下降开始日期;

- 对比第三方流量工具(GA/GA4、Server logs)与历史同期流量;

- 关注行业新闻/SEO社区(如Search Engine Roundtable、官方推特/X)确认是否有公共更新;

- 检查站点是否近期有大量变更(批量内容更新、模板升级、服务器配置变动、robots文件误改等)。

快速判定表(示例):

我通常在发现下降后把首要信息以简洁报告通报关键干系人:受影响范围、初步估计的营收影响、下一步行动计划。

第二步:影响评估 —— 量化损失并划分优先级

目标:把海量页面和关键词按照“恢复优先级”排序,集中资源先救高价值页面。

我会构建如下表格(Top-down):

- 把受影响的URL按“过去90天的自然搜索会话数 × 平均订单价值(或目标转化值)”计算预估损失;

- 标注每个URL的商业价值(高/中/低),并记录流量来源、设备分布;

- 计算恢复成本估计(低/中/高):例如小幅文案修正 vs 重写+外链建设。

示例表格字段:

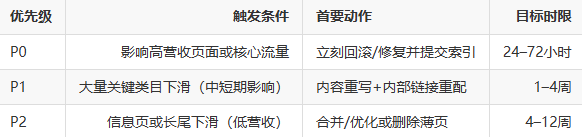

优先级定义(我常用):P0(紧急,影响营收且恢复成本低/中)、P1(高价值但需时间)、P2(信息型低商业价值)

注意:不要只看流量数字,也要看品牌词与长期SEO资产(链接、内容权威)。有些页面虽然短期流量低,但失去后长期重建成本极高。

第三步:快速应急 —— 可逆且低成本的稳定操作

目标:在最短时间内做出不破坏长期SEO资产的修复动作,缓解进一步下滑。

我常用的快速应急操作:

- 回滚近期模板/结构化数据/JS变更:如果你在更新前后出现下滑,优先回滚并监测效果;

- 修正明显的SEO错误:恢复意外的noindex、canonical错指、robots阻断;

- 临时移除过多广告/弹窗:广告密度过高会影响用户体验与评估;

- 修复重大性能退化:把LCP/INP回退到更新前水平(优先级高);

- 补充作者/出处信息(YMYL页面优先):快速展示作者资历与引用,降低E-E-A-T短板影响。

这些操作都是“可逆的”,即在没有彻底诊断前,我不主张进行大规模内容重写或外链采买以免造成更多不可控因素。

第四步:根因排查 —— 系统化诊断步骤

目标:找到核心问题所在(内容质量、技术、链接、负面信号或组合问题)。我的排查维度如下:

1. 内容质量与E‑E‑A‑T

- 检查下降页面的内容是否过时、薄弱或与查询意图不匹配;

- 对YMYL页面重点审查作者资历、引用来源与透明度;

- 使用文本相似度检测(与高排名页面比较)判断是否为抄袭或高度同质化。

2. 技术问题

- robots.txt、meta robots、x-robots-tag检查;

- canonical标签是否误指向其他页面;

- 站点地图(sitemap.xml)是否包含受影响页面;

- 服务器错误(5xx)或爬虫阻断日志分析;

- JavaScript渲染引发的索引差异(使用Fetch as Google或URL Inspection检验渲染结果)。

3. 链接与离线信号

- 快速审查是否出现大量垃圾外链或反向链接突然消失;

- 检查是否存在付费或低质量链接泄露的证据;

- 识别负面媒体报道或舆情(品牌信号)对E‑E‑A‑T的冲击。

4. 用户体验与行为信号

- 观察CTR、Dwell、Pogo-sticking的变动;

- 分流量来源(搜索/社媒/付费)来判断是否为搜索行为独有的下滑;

- 结合Core Web Vitals查看性能退化。

把上述排查维度形成一张诊断表,按“可证伪/可修复”的顺序逐项验证并记录证据,我认为这是非常重要的审计实践。

第五步:数据重建 —— 内容、结构与链接的可执行方案

当核心问题被定位后,进入数据重建阶段。我把工作拆成4个层面:内容重建、站点结构与内部链接、外链争议治理、测量与数据修复。

内容重建(Content Rebuild)

- 优先重写高价值薄页:对于P0页面,立刻安排主题专家重写或补充独特数据、案例与引用;

- 增加信任元素:作者档案、引用权威来源、发布日期与修订历史;

- 移除或合并重复/低价值页:把薄弱页面合并为一篇更有深度的权威页面(301重定向策略)。

示例流程:

- 内容评估(自动+人工) → 2. 编写Outline并征得法律/合规审核(若YMYL) → 3. 发布并标注修订日期 → 4. 提交索引请求并监测效果。

站点结构与内部链接(Internal Linking)

- 强化Topical Hubs:把相关主题聚合到专题页并通过内部链接传递权重;

- 检查Pagination与Canonical:确保没有错误的跨页Canonical导致权重流失;

- 利用Breadcrumb与facet控制:避免过多参数化URL被索引造成稀释。

我通常在页面重建后做一次内部链接矩阵优化,把重要链接从站点高权重页直接导向目标页面。

外链争议治理(Backlink Remediation)

- 若发现不自然链接激增,先做断链清单并向站长提交移除请求;

- 必要时准备Disavow清单(作为最后手段),并记录时间点与证据;

- 同时启动自然外链建设(PR、行业内容、数据报告)补强权威。

测量与数据修复(Measurement Repair)

- 确保GSC/GA数据采集正常(追踪代码是否被移除/修改);

- 建立索引与抓取监测(每日report),并记录所有变更以便回溯;

- 利用历史快照(archive.org)与内部版本控制追溯内容变更对排名的影响。

第六步:实验验证 —— 小流量试错与逐步放量

无论做了多少修复,最终都需要通过实验与对照来验证效果。我常用的方法:

- 分批发布:先在部分URL或地理区发布修复版本,观察2–8周效果;

- A/B或多臂实验:对标题、结构化数据、首屏内容做随机化修改;

- 外链建设分阶段:不要一次性发大量外链,分批观察每一波外链的影响。

记住:核心更新后的搜索系统会有延迟性、非线性反应,短期内某些页面可能波动剧烈。耐心和系统化记录是关键。

第七步:规范化与防护 —— 长期复原与抗脆弱性建设

恢复之后,我会把流程标准化,建立以下长期机制:

- 变更审核流程:所有大规模模板/结构/内容修改需要SEO/QA/法律三方签核;

- 质量评分卡与抽样审计:定期人工评估高风险页面(YMYL、交易页);

- 监控与告警:建立针对Core Web Vitals、索引量、流量异常的自动告警;

- 知识库与回溯记录:把每次更新的影响、证据与修复方案入库,供团队学习。

我强调把“恢复经验”上升为组织资产,这能显著缩短下一次修复的响应时间。

优先级矩阵(快速决策表)

下面是我常给高管和项目经理的决策矩阵,帮助快速分配资源。

沟通模版:对外与对内的关键信息点

对内(给高管):

- 摘要:何时开始、影响范围、预估每日营收损失、已采取的紧急措施、下一步计划;

- 里程碑:24/72小时进度、1周与1个月修复目标;

- 风险:外链/法律/合规风险说明。

对外(给公众或客户):

- 简短透明:我们发现了流量下滑,已在积极修复,相关功能/购买渠道不受影响;

- 不要在未确认的情况下指责搜索引擎或承诺即时恢复日期。

透明但谨慎的沟通能减少外部焦虑并给团队争取时间。

常见误区与我学到的教训

- 误区1:一次性大变动能快速恢复:很多团队在恐慌中做大幅改动,反而增加不确定性。我更倾向于分阶段、可回滚的小步快跑。

- 误区2:把外链当作灵丹妙药:外链有用,但必须与内容质量、用户体验配合,否则只是短期波动。

- 误区3:忽视测量基础:很多团队在危机时发现在重要事件并未被正确记录,导致无法回溯。这是最昂贵的失误。

结语:把危机变成强健性的机会

每一次核心更新创伤,既是挑战也是改进的契机。我在多个项目中看到:那些把修复当作一次系统性质量提升的团队,往往在6–12个月内比竞争对手获得更稳健且可持续的增长。

霓优网络科技中心是一家专注于网站搜索引擎优化(SEO)的数字营销服务提供商,致力于帮助企业提升网站在搜索引擎中的排名与收录效果。我们提供全方位的SEO优化服务,包括关键词策略优化、内容质量提升、技术SEO调整及企业数字营销支持,助力客户在竞争激烈的网络环境中获得更高的曝光度和精准流量。