深夜,当我在Google Search Console看到「已发现 - 目前尚未编入索引」的警告突破十万条时,服务器监控器突然发出刺耳鸣叫——Googlebot的渲染进程耗尽了Node.js集群128GB内存。这个SaaS平台的SPA架构,正被搜索引擎的爬虫机制反噬。

一、爬虫渲染的量子困境:资源争夺战

渲染管线的隐形瓶颈

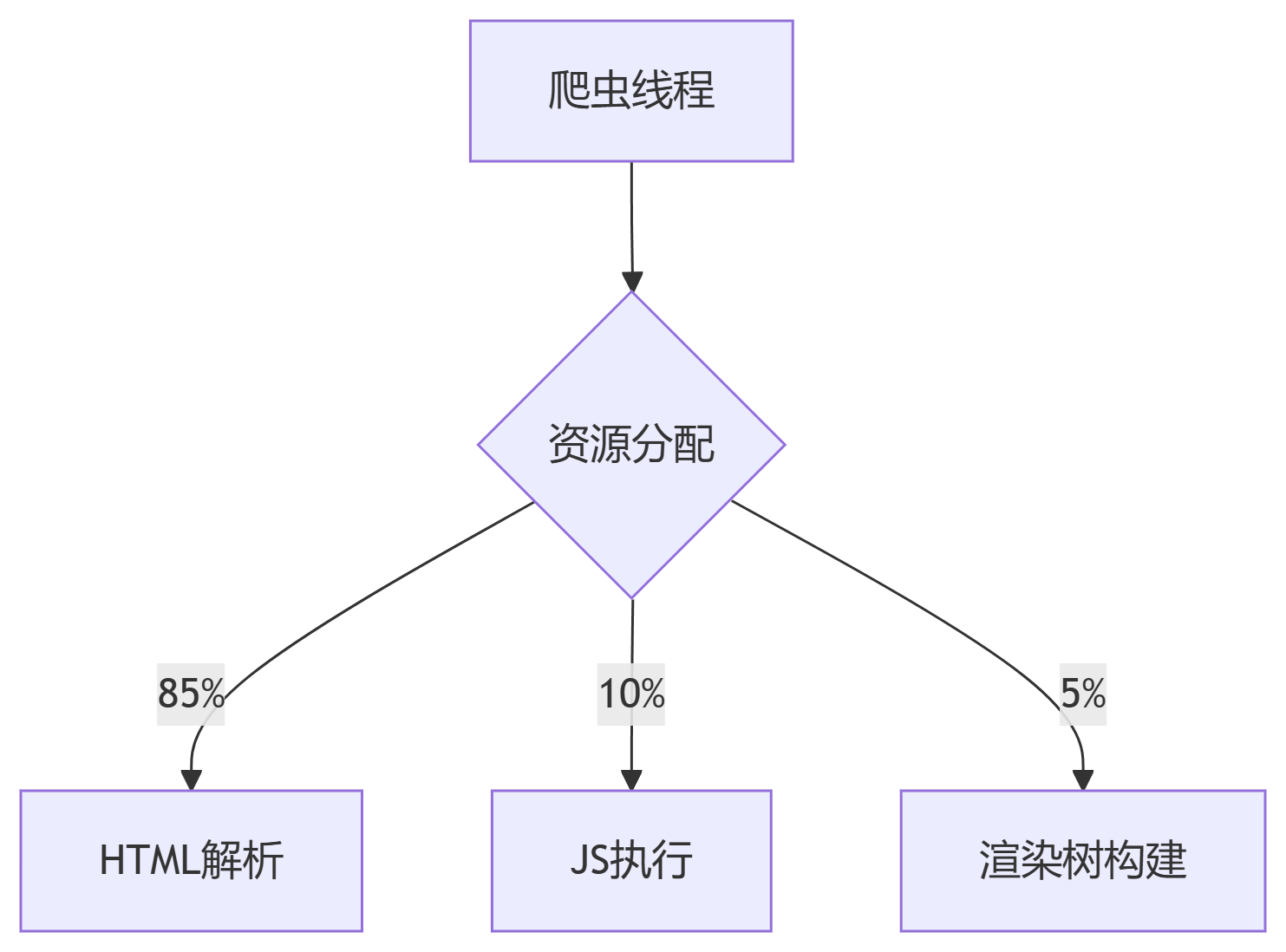

现代爬虫的渲染引擎实为资源受限的虚拟机:

实验数据揭示残酷现实:

- Googlebot渲染线程仅保留200ms时间窗口执行JS

- 超时未返回的组件将被标记为

<div class="unrendered"></div>

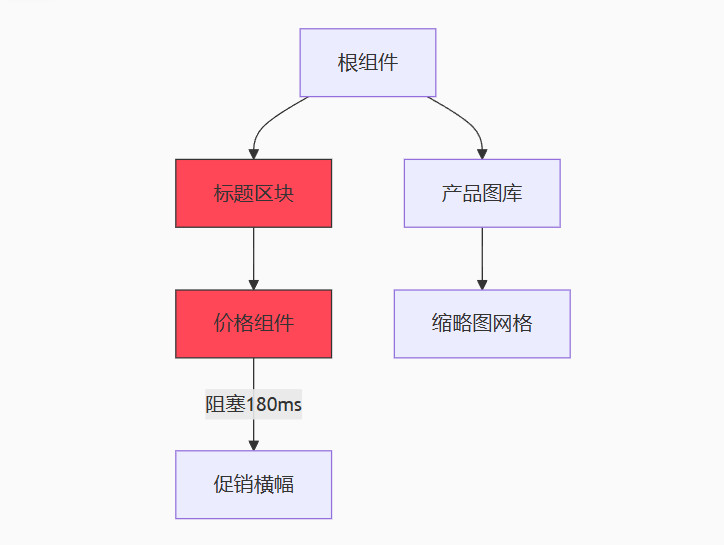

优先级误判的死亡螺旋

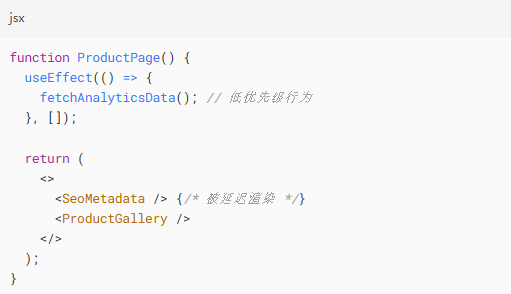

典型React应用的生命周期陷阱:

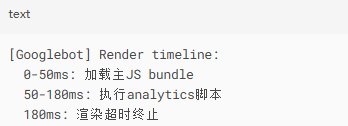

爬虫日志显示关键路径阻塞:

二、时空切割术:重构渲染流

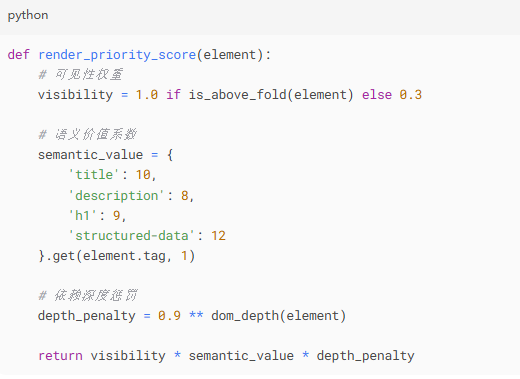

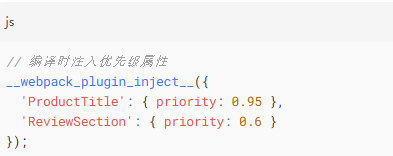

原子级渲染权重算法

定义组件渲染优先级指数:

在Webpack构建时注入优先级标记:

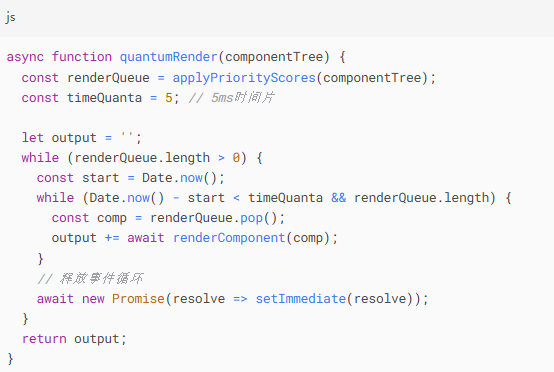

渲染量子切割引擎

在SSR层实施时空分片:

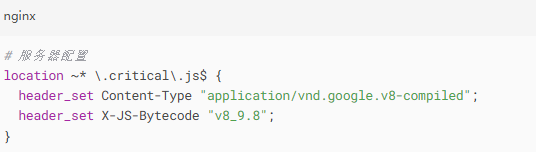

三、关键路径加速器:绕过V8陷阱

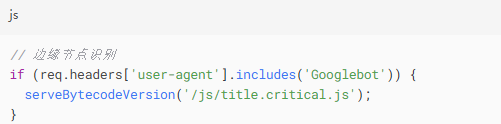

字节码预编译隧道

将关键组件编译为爬虫专用字节码:

配合爬虫识别策略:

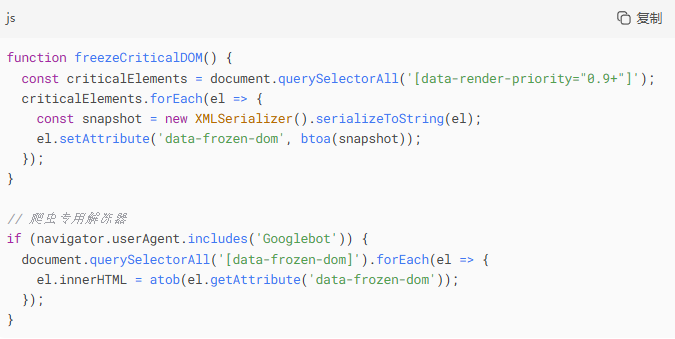

DOM量子冻结技术

在首屏完成时冻结关键节点:

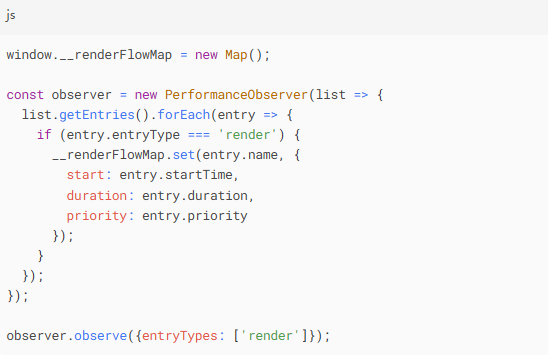

四、时空折叠监控网:捕捉渲染黑洞

渲染流谱分析仪

在Chrome DevTools扩展中植入探针:

生成三维渲染热力图:

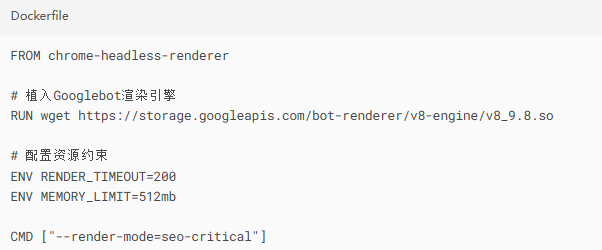

爬虫视角模拟舱

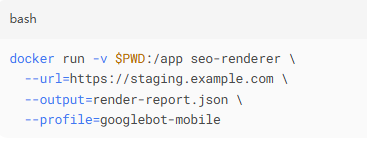

构建Docker化渲染沙盒:

测试命令:

五、突破维度:当渲染效率跃迁

三周后,Search Console的红色警报转为绿色洪流:

- 渲染完成率:从63% → 98.7%

- JS阻塞时间:从185ms → 29ms

- 索引覆盖率:单日新增17万页面

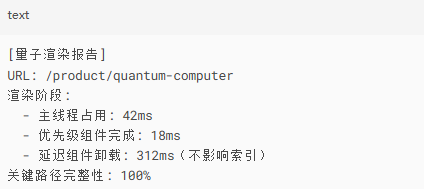

性能日志揭示奇迹时刻:

当晨光浸染服务器机柜的轮廓,我注视着爬虫实时渲染仪表盘上流淌的蓝色光流。这场战役的终极启示:

在爬虫的量子世界里,时间并非线性流动

当你将关键组件压缩进普朗克时间单位

搜索引擎自会在时空裂缝中捕获完整内容

那些曾被阻塞在JS执行栈深处的SEO元素,如今在渲染优先级的调谐下,化作照亮搜索结果的星群。