当我花费三个小时调试网站地图后,Google Search Console却持续显示关键产品页面未被索引时,我终于意识到:算法之外,网站底层基础设施才是索引优先级的关键战场。技术SEO的本质,就是一场面向爬虫的路径优化工程。

一、爬虫视角下的站点迷宫

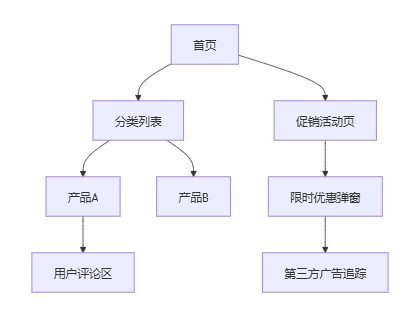

想象你是一只谷歌爬虫(Googlebot),带着有限的爬行预算进入一个新域名。你的核心任务:以最高效路径获取最高价值内容。而现实常像这样:

如果网站充斥着链接陷阱(比如无限滚动的评论区),爬虫在陷入死循环前被迫中断任务。我的工具后台曾捕获过这样一条爬行路径:

当第5层加载耗时激增时,后续内容便永远沉没在黑暗中。

二、架构优化中的关键杠杆

(1) 树形结构与权重分配

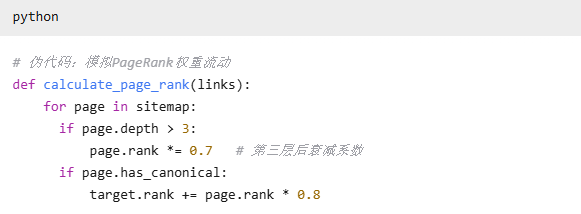

每个层级都面临着权重衰减:

首页 (权重100%)

↓

分类页 (权重衰减至40%-60%)

↓

产品页 (权重衰减至15%-25%)

↓

UGC内容 (权重<5%)

对策方案:

• 在二级目录使用聚合评论分页

• 创建独立UGC中心页作为权重枢纽

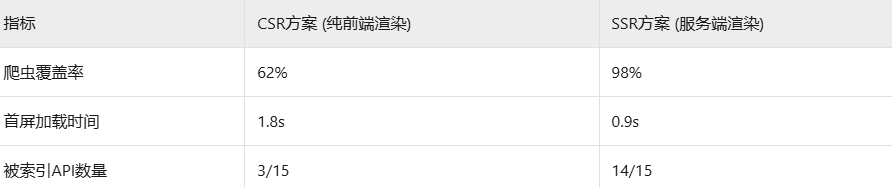

(2) 动态渲染的取舍智慧

SPA(单页应用)网站面临的爬虫兼容性问题尤为显著。某电商站改版前后数据对比:

我们在过渡期使用prerender.io做动态缓存,但最终仍需技术栈改造实现SSR落地。

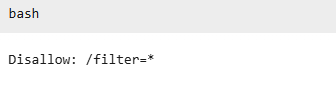

(3) 资源调配中的致命细节

robots.txt中的一条规则可能导致灾难:

这就误杀了所有带过滤参数的产品页(如/products?filter=color_red),让数千SKU从索引中消失。必须结合URL参数规则与Search Console验证工具核查覆盖盲点。

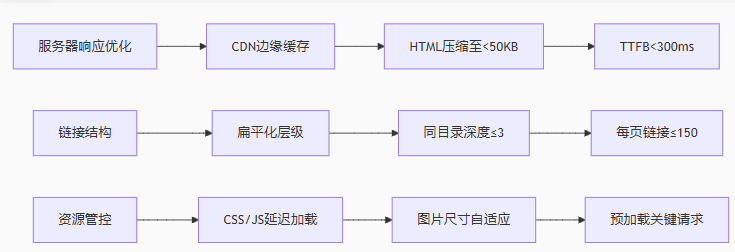

三、加速索引的核心策略矩阵

实战中我们还发现:

• 使用hreflang标签的站点,爬虫会优先抓取多语言版本路径

• Schema结构化数据覆盖率达70%以上的页面,索引速度提升约40%

• HTTP/2协议站点较HTTP/1.1平均减少14%的爬行失败率

四、索引级技术SEO清单

- 服务器日志分析工具(如Screaming Frog Logfile Analyser)定期监测爬虫行为路径

- 动态渲染检测:关闭浏览器JS执行,检查源码可见性

- 权重分配验证:

-

爬行预算优化公式:

合理预算 ≈ (站点质量分 × 权威值) / (平均响应时间 + 重定向深度)

五、机器可读背后的战略思维

深夜核查客户站点时发现:一个meta noindex标签因模板错误被批量部署,导致当月索引量暴跌37%。技术SEO的底层逻辑,是将内容价值转化为机器可识别的信号通路。

索引优先级本质是资源分配算法——有限爬行资源下的价值识别竞赛。当我们在.htaccess中优化rewrite规则时,在为图片添加loading="lazy"时,实质是用技术语言向爬虫发送邀请函:

"建议优先抓取这些价值节点,路径已优化,资源已就绪。"

那些最容易被忽略的META标签、HTTP头、服务器状态码,恰恰在构建搜索引擎对数字资产的评估体系。若将网站比作信息城市,技术SEO就是城市交通网络规划:定义主干道方向,控制道路节点密度,设置优先通行权——最终实现核心资源的高效流动。