我始终认为,SEO不仅仅是内容层面的艺术,它更是一个底层工程的较量,尤其当我们进入“技术型SEO”的赛道。从网站结构到URL规范,从内链布置到爬虫路径优化,每一个技术环节都决定了搜索引擎能否真正读懂你的网站。真正有效的SEO提升,不是单点突破,而是结构性革新。我将从自身为多个跨境电商、B2B SaaS、新闻门户项目实施技术型SEO的实操经验出发,系统拆解技术SEO的核心环节与执行逻辑。

一、网站结构:SEO系统优化的起点

1.1 网站结构决定了SEO的“爬虫可见性”

网站结构对于SEO的意义,远远不只是用户体验那么简单。它直接决定了:

- 搜索引擎是否能高效抓取你的网站内容

- 页面是否被合理归类、传递权重

- 内容是否被快速索引

在给一家B2B工业品牌优化SEO架构时,我们将其原先杂乱无章的二级、三级页面结构,重新划分为“主题内容 > 功能模块 > 页面单元”三层体系。短短两个月,爬虫覆盖率提升至97%,索引页增长42%。

1.2 理想的网站结构:三层金字塔模型

理想的网站结构应该如同信息架构的金字塔,层次清晰、权重聚焦:

首页

│

├── 核心分类页(如功能模块、产品类目、服务体系)

│ ├── 子分类页(细分功能、具体产品、具体服务)

│ └── 详情页(长尾关键词内容页、落地页)这种结构有助于形成“权重流通路线”,让核心页面更容易获得内链支持、搜索引擎更快地抓取更新。

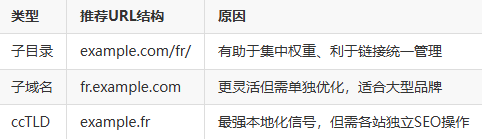

1.3 多语言与国际站的结构策略

如果你像我一样做过多语言或跨境网站,会发现站点结构对SEO影响更大。以下是我在部署多语言SEO时的结构建议:

我的建议是:中小企业选子目录,大型企业考虑子域名+hreflang+本地服务器组合。

二、URL规范:抓取友好与权重传递的通道

2.1 URL优化的三大标准

一个SEO友好的URL,应当满足以下标准:

- 可读性强:如 /seo-tutorial/ 而不是 /index.php?id=3435

- 关键词嵌入:如 /b2b-marketing/lead-gen/

- 层级控制:避免超过3级结构,否则抓取深度受限

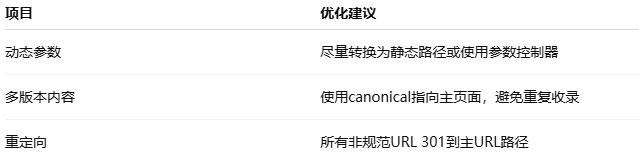

实际操作中,我会使用以下规则统一管理URL:

2.2 URL与分页、标签页、搜索结果页的管理

这些页面如果不加限制,极易造成“抓取陷阱”和“索引污染”。我通常采用以下组合策略:

- 分页页:用

rel=prev和rel=next进行指引 - 搜索结果页:加noindex并在robots.txt中屏蔽抓取

- 标签页:只保留核心标签,避免长尾标签索引重复内容

三、内链策略:权重流动与结构信号的引导器

3.1 内链并非随意添加,而是信息架构的延展

我在优化内容站、媒体站时发现:90%的站点内链策略都极为混乱。很多人只是为了“增加PV”而乱加链接,结果造成搜索引擎路径重复、页面权重稀释。正确的做法是:让内链成为搜索引擎理解页面结构的桥梁。

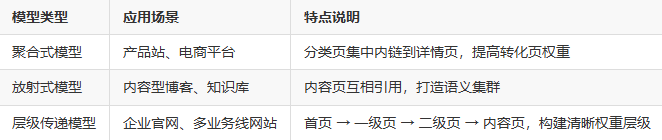

3.2 内链分布的三种模型

我会根据网站类型选择以下内链策略模型:

以“内容聚合型站点”为例,我会将所有关于SEO优化的文章,通过专题页聚合,并互相引用相关子主题,增强主题相关性。

3.3 Anchor文本策略

很多人忽略了Anchor文本(链接锚文字)对SEO的作用。我的做法是:

- 主要锚文本使用目标关键词变体,如“技术型SEO策略”→指向SEO策略页面

- 避免通用词如“点击这里”、“了解更多”

- 控制同一关键词锚文本指向的唯一性,防止分散信号

四、站点地图与robots协议:SEO抓取效率的守门人

4.1 sitemap.xml的配置策略

一个完整的sitemap不仅仅是一个列表,它应该分模块、分层次组织。以下是我常用的结构:

/sitemap.xml

├── /sitemap-posts.xml

├── /sitemap-products.xml

├── /sitemap-pages.xml

└── /sitemap-categories.xml通过分模块提交,方便搜索引擎精准更新、提升索引速度。

4.2 robots.txt的精准控制

robots.txt是搜索引擎访问的第一站,我常用规则如下:

User-agent: *

Disallow: /search/

Disallow: /tag/

Allow: /wp-content/uploads/

Sitemap: https://example.com/sitemap.xml重点是:不让搜索引擎浪费“爬虫预算”在无价值页面上。

五、技术诊断:SEO问题识别与监控机制

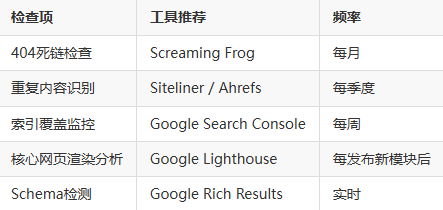

5.1 建立技术型SEO审计系统

我为每个客户都设计一套“SEO技术诊断表”,如下:

5.2 监控爬虫行为:分析日志才是高手做法

通过访问日志,可以识别出:

- 哪些页面被频繁抓取但未收录

- 哪些页面从未被抓取

- 是否有爬虫浪费资源在低价值路径

我通常用ELK或Logz.io监控,并设置自动报警机制,比如:某页面7天内抓取频次下降80%,立刻检查其内链或权重路径。

六、技术+内容协同:打造搜索引擎与用户双满意的结构

技术型SEO并非只属于技术团队,它必须与内容团队协作。以下是我在实践中形成的一套协同机制:

七、结语:技术型SEO的未来在于系统性演化

当今的SEO,早已不是“发布几篇文章、换个title”就能有效果的时代。真正的SEO提升,尤其是在中大型网站、出海电商、内容平台、B2B SaaS等场景中,技术型SEO的力量是决定性因素。

从网站结构的逻辑搭建,到URL的可读性与唯一性;从内链系统的权重流动,到爬虫路径的精准控制;从Schema的结构表达,到日志级行为监控——这一切构成了一个高效、稳定、可持续增长的SEO底层体系。

在这个体系中,技术不是点状解决方案,而是复利增长的基础设施。而我,也会继续在这个系统性演进中,持续打磨最适合每个客户的SEO技术路径。

霓优网络科技中心是一家专注于网站搜索引擎优化(SEO)的数字营销服务提供商,致力于帮助企业提升网站在搜索引擎中的排名与收录效果。我们提供全方位的SEO优化服务,包括关键词策略优化、内容质量提升、技术SEO调整及企业数字营销支持,助力客户在竞争激烈的网络环境中获得更高的曝光度和精准流量。