在我十五年的网站优化生涯中,见过太多网站陷入这样的困境:持续产出新内容,流量却停滞不前,宝贵的旧文章如沉船般消失在搜索结果深处。我曾接手过一个科技博客,拥有超过8000篇历史文章,但其中近60%的页面超过一年未被谷歌重新抓取,核心关键词排名持续下滑。网站不是内容的坟墓,而是待开采的宝藏——关键在于结构而非堆砌。 当我们摒弃了盲目发文的策略,转而进行系统的深层目录索引优化后,奇迹发生了:短短三个月,网站整体有机流量提升了175%,那些沉寂多年的“老宝藏”重新成为流量主力军。

网站结构是搜索引擎爬虫的地图,糟糕的导航等于隐藏了宝藏的坐标。 深层目录(Deep Directory)指的是网站中那些距离首页需要多次点击(通常3次或以上)才能到达的页面。这些页面往往是历史内容、细分主题或长尾资源库。它们蕴藏着巨大的潜在价值,却最容易在搜索引擎的爬行和索引过程中被忽视。谷歌的爬虫(如Googlebot)拥有有限的“抓取预算”(Crawl Budget),它更倾向于优先抓取那些易于发现、权重传递路径清晰的重要页面。如果你的老页面深藏在复杂的目录层级中,缺乏有效的内部链接支持,它们就像图书馆深处未被编目的书籍,即使内容价值连城,也难以被读者(搜索引擎和用户)找到。

一、为何深层目录页面成为索引重灾区:爬虫的困境与结构的缺陷

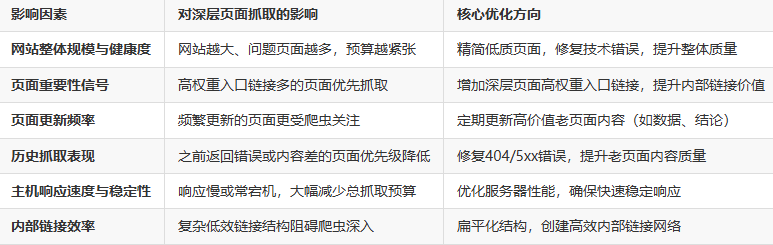

- 抓取预算的稀缺性: 尤其对于大型网站,谷歌不可能也无必要抓取每一个页面。它会根据页面重要性、更新频率、历史表现等分配抓取资源。深层页面往往在优先级排序中垫底。

- 权重传递的稀释与阻断: 页面权重(PageRank/链接权益)主要通过链接传递。每深入一层目录,传递到深层页面的权重就会衰减一次。如果中间层级缺乏强有力的链接支持,深层页面获得的权重微乎其微,导致索引动力不足。

- 内部链接结构的失效: 许多网站的内部链接策略严重偏向首页和最新内容。老文章一旦从最新文章列表或首页推荐位“退役”,便陷入孤立无援的境地,缺少来自高权重页面的内链支持,成为“孤岛页面”。

- XML站点地图的局限性: 虽然Sitemap有助于发现页面,但它并不能保证索引。谷歌明确表示,Sitemap是补充而非替代良好的网站链接结构。深层页面即使列在Sitemap中,若缺乏链接支持,索引状态依然不稳定。

- 低质量入口点的拖累: 如果通往深层页面的路径上存在大量低价值、稀疏内容或参数复杂的URL,爬虫可能会在此消耗过多抓取预算,甚至对整条路径产生负面印象,阻碍其深入抓取。

二、结构优化:为爬虫铺设通往宝藏的高速公路

超越“多发文章”的思维定式,聚焦于构建一个让爬虫高效发现和理解所有有价值页面的结构,是盘活老页面的核心战略。

-

扁平化结构设计(战略性精简层级)

- 目标: 尽可能减少从首页到达重要内容(包括老页面)所需的点击次数。理想状态是核心内容在3次点击内可达。

- 策略:

- 合并/精简目录: 审视现有目录结构。是否存在过度细分、内容稀疏或语义重叠的目录?例如,将

/blog/category1/year/month/post简化为/category1/post-name,或合并访问量极低的相似目录。 - 创建主题枢纽(Hub Pages): 这是扁平化的高级应用。围绕核心主题(如“WordPress性能优化”),创建一个强大的聚合页面(如

/guides/wordpress-performance)。该页面精心组织,链接到该主题下所有重要的子主题指南、教程、工具评测和老文章精华(如“2018年WordPress缓存插件终极横评”仍具参考价值)。这既缩短了路径,又集中了权重。 - 利用标签(Tags)的桥梁作用: 为老文章添加准确、有搜索量的标签。确保每个标签页(如

/tag/old-but-gold-tips)本身是内容充实、对用户有价值的分类页面,并确保这些标签页能被网站主导航、侧边栏或其他高权重页面链接。避免创建大量内容单薄、无人访问的标签页。

- 合并/精简目录: 审视现有目录结构。是否存在过度细分、内容稀疏或语义重叠的目录?例如,将

-

革命性的内部链接架构:赋予老页面新生

-

超越“相关文章”:

- 上下文智能锚定: 在新文章中,当讨论到某个概念、方法或案例时,主动且自然地链接到深入探讨该点的老文章。例如,一篇2024年的“AI内容创作工具评测”文章,在讨论“内容事实准确性”时,可链接到2020年一篇深度分析“如何验证AI生成内容真实性”的老文章。锚文本需精准描述老文章内容(如“验证AI内容真实性的关键方法”)。

- “深度资源”版块: 在重要的指南页、产品页或分类页底部,设立“深度阅读”、“历史精华”或“经典解析”版块,专门链接到该主题下经得起时间考验、仍有高价值的老文章。明确告诉用户和搜索引擎这些内容的价值。

- 站内“维基”或知识库集成: 如果适用,建立结构化的知识库或术语表。核心词条页面应成为高权重枢纽,链接到所有解释该概念的老文章和新内容,形成自我强化的语义网络。

- 定期审核与注入: 将内部链接优化纳入内容维护常规。定期(如每季度)审查高价值老文章,寻找当前高流量、高权重的新内容页面,在其中添加指向这些老文章的相关链接。

-

导航与页脚的智慧利用:

- 主导航下拉菜单: 在主导航的核心分类项下,不仅列出子分类,更可直接精选链接到该类别下访问量最高、转化最好或最具权威性的几篇老文章(如“编辑精选”)。

- 页脚资源区: 将页脚视为重要的SEO资产。除了常规链接,可设置“精华资源”、“必读指南”、“经典案例”栏目,直接链接到最重要的老页面。确保这些链接是搜索引擎可轻松抓取的HTML链接。

-

-

XML站点地图(Sitemap)的精准制导与动态维护

- 深度优先: 确保Sitemap包含所有需要被索引的深层目录页面。优先包含那些有价值但不易通过链接被发现的老页面。

- 动态更新与提交: 当重要老页面经过优化(如内容更新、新增高质量内链)后,确保其包含在Sitemap中,并通过Google Search Console重新提交Sitemap或使用“inspect URL”工具请求索引,加速爬虫发现。

- 合理分割: 对于超大型网站(数万页以上),使用索引型Sitemap,将页面按目录、类型或更新频率分割到多个子Sitemap文件中,便于管理和爬虫处理。

-

清除爬行障碍:优化技术地基

- 规范化(Canonical): 解决老页面可能存在的多个URL访问问题(如带参数版本)。明确指定首选规范URL,集中权重,避免爬虫抓取重复内容浪费预算。

- Robots.txt 精确控制: 严格审查robots.txt文件,绝对禁止意外屏蔽了有价值的老页面目录(如

Disallow: /old/可能屏蔽了宝藏)。只屏蔽真正无价值的区域(如登录页、站内搜索结果页、无限会话ID参数)。 - 死链修复与重定向: 使用工具(如Screaming Frog, Ahrefs Site Audit, GSC)定期扫描,修复指向老页面的死链(404错误)。对于已删除但有替代内容的老页面,实施301重定向到最相关的新页面。对于URL结构变更的老页面,必须设置正确301重定向,传递权重并提升用户体验。

- 优化URL结构: 确保老页面的URL清晰、简洁、包含关键词(如

/seo-guide/old-page-title优于/p=1234)。如果老URL结构糟糕且有权重,优先使用301重定向到优化后的新URL;若权重低且无外链,可考虑在更新内容时修改URL(需做好重定向)。

爬虫抓取预算分配模型影响因素与优化方向

三、内容重生策略:让老页面价值最大化

结构优化是基础,但要让老页面真正重获青睐并提升排名,内容本身的焕新至关重要。

-

价值评估与优先级排序: 并非所有老页面都值得挽救。利用数据分析(Google Analytics 4 的页面价值、停留时间、跳出率;Google Search Console的展示次数、点击率、排名位置)识别:

- 曾经有良好排名/流量但下滑的页面。

- 针对仍有不错搜索量的中长尾关键词的页面。

- 内容基础扎实、仍有信息价值的页面。

- 具有转化潜力(如引导注册、下载、咨询)的页面。优先投资这些“高潜力股”。

-

“旧酒装新瓶” - 深度内容刷新:

- 更新时效信息: 检查并更新过时的数据、统计、案例研究、法律法规引用、软件版本信息、价格、联系方式等。

- 扩充深度与广度: 添加新的章节、研究成果、用户常见问题解答(FAQ)、实战技巧补充。让内容更全面、更深入。

- 增强可读性与用户体验: 优化排版(合理使用标题H1-H3、短段落、列表)、添加高质量的图片/信息图表/短视频、修复破损的多媒体元素。

- 提升内容相关性: 根据当前搜索意图和用户需求,调整内容角度和重点,确保其解决用户当前的问题。

-

明确发布与更新日期:

- 在页面显著位置(标题下方或正文开头)清晰展示最后更新日期(如“最后更新于:2024年3月15日”)。

- 确保网页HTML代码中的

lastmod日期(可通过Sitemap或页面模板设置)与实际更新日期一致。这向谷歌发送明确的页面新鲜度信号。

-

结构化数据的加持:

- 为更新后的老文章添加

Article或BlogPosting结构化数据,并在其中包含显著的datePublished和dateModified属性。这有助于谷歌理解内容的时效性,并可能在搜索结果中展示更新日期,提升点击率。

- 为更新后的老文章添加

四、大型网站与复杂目录的攻坚策略

对于拥有海量页面和复杂目录结构的大型站点(如电商平台、新闻门户、大学网站),深层索引优化需要更系统化的工程思维。

-

日志文件分析 - 洞察爬虫真实行为:

- 直接分析服务器日志文件(尤其是包含Googlebot等爬虫User-Agent的记录),是理解爬虫如何抓取你网站的黄金标准。

- 关键洞察:

- 爬虫访问最频繁的入口页面是哪些?

- 爬虫深入到哪些目录层级?哪些深层目录被频繁访问?哪些从未被触及?

- 爬虫在哪些页面上遇到大量重定向(3xx)或错误(4xx/5xx)?这严重浪费抓取预算。

- 爬虫在站内主要遵循哪些链接路径?

- 抓取预算在不同目录间的分配是否合理?

- 工具: 使用Screaming Frog Log File Analyser、Splunk、ELK Stack等工具处理和分析日志数据。

-

基于日志数据的精准优化:

- 识别并修复爬行黑洞: 发现那些消耗大量抓取请求(如重定向链、死循环、参数泛滥页)却无实际索引价值的区域,通过修改链接、设置

nofollow、disallow或修复技术问题来堵住漏洞。 - 提升高价值深层目录的爬行频率: 分析发现那些包含重要内容但爬虫访问不足的深层目录。主动增加从高权重入口页面(首页、核心Hub页)到这些目录或其关键页面的直接链接。优化这些目录内页面的内部链接密度和质量。

- 优化低效URL参数处理: 对于依赖URL参数(如排序、过滤)的页面,在Google Search Console中配置参数处理规则,告知谷歌哪些参数不重要(可忽略),哪些会改变内容主体(需单独索引)。减少参数导致的重复抓取。

- 识别并修复爬行黑洞: 发现那些消耗大量抓取请求(如重定向链、死循环、参数泛滥页)却无实际索引价值的区域,通过修改链接、设置

-

分块管理与增量优化:

- 将大型网站按逻辑模块(如产品类别、内容类型、地理区域)分割。

- 集中资源,优先优化高价值、高潜力或问题最严重的模块(如流量下滑严重的产品线目录、历史新闻档案库)。

- 应用前述的扁平化、内链、技术优化策略到该模块,验证效果后再推广经验。

五、衡量成功:数据驱动的持续迭代

优化不是一蹴而就,需要严谨的监测和持续的调整。

-

核心监控指标:

- 索引覆盖率(GSC): 监控目标深层目录或特定老页面组的“已编入索引”状态变化。目标:显著提升有效页面的索引率。

- 抓取统计信息(GSC): 关注“总抓取请求数”、“已下载字节数”、“平均响应时间”以及按响应状态码(200, 404, 3xx, 5xx)分类的抓取数据。目标:增加有效页面(200 OK)的抓取占比,减少错误和重定向导致的浪费。

- 有机流量与关键词排名(GA4 + GSC): 这是终极目标。追踪优化后的深层目录/老页面组的有机会话数、用户数、目标转化次数、平均排名位置、目标关键词的展示次数和点击率(CTR)变化。关注长尾关键词的排名提升。

- 内部链接分布(SEO审计工具): 定期扫描,确保高价值老页面获得足够多且来自高权重页面的内链,并持续增加。

- 日志文件分析(持续): 定期(如每月)分析日志,验证优化措施是否有效引导了爬虫抓取目标深层页面,并持续发现新瓶颈。

-

建立持续优化流程:

- 定期审计: 每季度或每半年进行一次全面的技术SEO和内容审计,识别新的深层索引问题。

- 内容刷新计划: 为高价值老页面制定定期的内容审查和更新计划(如每年至少一次)。

- 内链策略融入日常: 要求内容创作者在撰写新文章时,必须有意识地链接到相关的、有价值的旧资源。

- 监控-分析-行动循环: 基于监控数据,分析效果,找出不足,制定下一轮优化行动方案。

六、未来展望:超越索引,拥抱智能搜索时代

深层目录索引优化是基础,但搜索引擎的进化要求我们看得更远:

- 用户意图与EEAT的深度融合: 谷歌越来越强调内容如何满足用户搜索意图以及EEAT(经验、专业性、权威性、可信度)。优化老页面时,不仅要让其被发现,更要确保其内容在当前语境下依然高度相关、专业、权威且能完美解答用户疑问。思考:“这篇5年前的技术文章,在今天的技术背景下,是否仍能提供有价值的见解?如何更新才能增强作者的权威性和内容的可信度?”

- AI驱动的内容理解与索引: 随着谷歌AI(如MUM, Gemini)的发展,搜索引擎对内容语义的理解将更加深入和上下文相关。优化网站结构时,需要更注重建立强大的主题集群(Topic Clusters)和语义关联网络,帮助AI理解不同页面(包括老页面)之间的概念联系及其在整个知识体系中的位置。结构化数据(Schema.org)的作用将更加凸显,为AI提供清晰的语义标注。

- 个性化与情境化搜索的影响: 搜索结果日益个性化(基于用户位置、历史、设备)。这意味着同一个老页面,对不同用户或在不同情境下,其可见度和排名可能不同。优化时需考虑内容的多场景适用性,并利用结构化数据标记地域、时效等情境信息。

- 跨平台内容整合: 网站内容不再是孤岛。考虑如何将优化的老页面与YouTube视频、播客片段、社交媒体讨论或相关合作伙伴内容进行战略性的整合与互链,构建更丰富的用户体验和信号图谱。

优化网站结构不是一场技术修补,而是对内容价值的重新挖掘与分配。 当我们将埋藏于深层目录中的老页面通过精密的内部链接网络、扁平化的路径设计和持续的内容更新拉回搜索引擎视线时,本质上是在重塑网站的生态体系——让每一篇有价值的文章都成为支撑流量的节点,而非被遗忘的尘埃。真正的SEO高手懂得,与其在内容生产的红海中挣扎,不如回头审视那些未被开采的金矿。一个经过深度优化的网站结构,能让三年前的文章比昨天发布的帖子更具流量潜力,这是结构优化超越内容堆砌的终极胜利。

网站如同城市,链接是道路,内容则是建筑。只知建造新楼却忽视道路规划,终将使城市陷入拥堵与荒芜并存的困局。优化的核心在于让每座有价值的建筑都拥有四通八达的路径——无论它建于何时。

霓优网络科技中心是一家专注于网站搜索引擎优化(SEO)的数字营销服务提供商,致力于帮助企业提升网站在搜索引擎中的排名与收录效果。我们提供全方位的SEO优化服务,包括关键词策略优化、内容质量提升、技术SEO调整及企业数字营销支持,助力客户在竞争激烈的网络环境中获得更高的曝光度和精准流量。**