作为一名深耕SEO多年的从业者,我经常遇到网站运营者向我反映,网站总收录量停滞不前,即使不断更新内容,流量和收录依然没有明显提升。实际上,导致网站收录量停滞的原因往往藏在一些不易被注意的技术盲区中。无论你的站点规模大小,只要忽视了这些技术细节,都会严重影响搜索引擎对网站的抓取和索引,进而造成收录瓶颈。

今天,我将结合自己多年的实战经验,围绕**“网站总收录量停滞?你需要排查这五个技术盲区”**这一主题,深度剖析这五个常见且容易被忽视的技术问题,并提供实用的排查与优化方案,帮助你突破收录瓶颈,提升网站整体SEO表现。

一、爬虫抓取受阻:收录停滞的头号“拦路虎”

网站被搜索引擎收录的第一步是爬虫抓取,任何影响爬虫访问和抓取页面的因素,都会直接导致收录停滞。

常见爬虫抓取障碍

-

robots.txt配置错误

我经常看到网站因为一时疏忽,把整个目录或重要页面加入了robots.txt的禁止抓取规则中,直接断绝了爬虫抓取通路。比如Disallow: /一不小心就让整站陷入“黑洞”。 -

noindex标签滥用

很多内容管理系统会默认给某些页面加上noindex标签,或在模板里错将noindex写入核心页面,导致页面无法被索引。 -

服务器响应异常

服务器宕机、502错误、响应超时都会让爬虫无法抓取页面,我曾遇到某客户服务器带宽不足,爬虫访问高峰时段频频超时,导致页面长期未被收录。 -

CDN或防火墙误拦截

尤其是启用了安全防护的CDN,有时会误将搜索引擎爬虫IP屏蔽或限速,降低抓取效率。

我的排查建议

我习惯用Google Search Console的“URL检查”功能,实时检测关键页面的抓取状态,同时结合服务器日志分析爬虫访问记录,找出异常请求或响应错误。另外,robots.txt规则一定要定期复核,确保没有无意屏蔽核心内容。

二、页面内容重复和低质问题

收录停滞往往与内容重复或低质量内容泛滥密不可分。

内容重复的表现形式

-

URL参数导致同一内容多个版本

动态参数如?sort=asc、?ref=xxxx会生成大量内容重复的页面,搜索引擎不喜欢这种“重复垃圾”。 -

标签页、分页页堆积重复内容

电商或资讯站常见问题,标签页和分页如果没有合理设置canonical标签或者noindex,会导致同质页面充斥索引库。 -

模板化内容和轻内容

很多站点为了“充量”,批量生成几乎一模一样的文章,这种低质内容反而拖累网站整体权重。

实战经验分享

我通过设置规范的canonical标签,告诉搜索引擎哪个URL才是权威版本,有效避免了重复收录。另外,针对分页、标签页我建议合理使用noindex, follow标签,让搜索引擎抓取内部链接但不收录无效页面。同时,我坚持每篇文章保持独特的视角和深入的内容,避免模板化写作。

三、内部链接结构混乱,导致爬虫爬取效率低下

内部链接是搜索引擎发现和爬取网页的重要通路。内部链接设计不合理会让爬虫难以有效覆盖所有页面,影响收录。

内链问题具体表现

-

孤立页面

部分页面没有任何内链指向,爬虫难以找到,结果长期不被收录。 -

层级过深

核心页面距离首页超过4-5次点击,爬虫抓取优先级降低,收录变慢。 -

锚文本不合理

使用无意义或统一的锚文本,比如“点击这里”,不能帮助爬虫理解页面主题。

优化技巧分享

我一般建议构建扁平化的网站结构,确保所有重要页面都能在3次点击内从首页访问。同时,每个页面的内部链接要覆盖多个相关主题,用精准的关键词作为锚文本,提升搜索引擎对目标页面的语义理解。此外,定期用爬虫工具检测孤立页面,及时修复。

四、索引资源受限导致收录量停滞

大型网站和新站常会遇到索引资源受限的问题,简单来说就是搜索引擎分配给你网站的抓取和索引资源有限。

造成索引资源受限的因素

-

大量低质量页面占用资源

死链、内容稀疏页面占用爬虫资源,真正重要的页面无法及时被抓取。 -

站点权重较低

新站或权重较低网站的抓取预算有限,需要时间积累。 -

服务器性能不足

服务器响应缓慢也会限制爬虫抓取频率。

我的优化方法

我通常会先清理网站的低质页面,删除或合并内容重复、流量低的页面。同时,合理制作并提交高质量的XML Sitemap,引导搜索引擎优先抓取有价值的内容。此外,保持服务器的稳定和快速响应,确保爬虫能顺畅访问。

五、结构化数据缺失或错误影响收录效率

结构化数据是搜索引擎理解网页内容和页面关系的重要工具。缺乏正确的结构化数据会影响收录速度和搜索结果展示。

结构化数据常见问题

-

未使用schema.org标准标记

页面没有加入任何结构化标记,搜索引擎难以准确理解页面信息。 -

格式错误或数据不完整

JSON-LD、Microdata格式有误或者必填字段缺失,会导致结构化数据失效。 -

标记内容与页面实际不符

结构化数据与页面内容不匹配,可能导致惩罚。

优化经验

我推荐在核心内容页加入准确的Article、Breadcrumb、FAQ等schema标记,用Google的Rich Results Test工具反复验证。结构化数据不仅加快收录,还能获得更丰富的搜索展示,提升点击率。

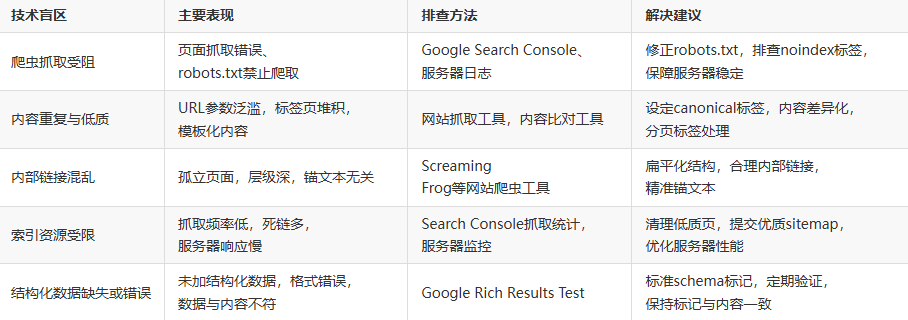

技术盲区排查总结表

总结

网站总收录量停滞绝非偶然,往往是多重技术盲区叠加的结果。作为一名专业SEO人员,我深刻体会到,只有从爬虫抓取、内容质量、内部结构、资源分配到结构化数据五大方面全面排查,才能真正找到症结所在,精准施策。收录量提升不是一朝一夕之功,而是长期细致优化的积累。借助科学的排查方法和实用的优化方案,我帮助多个项目突破了收录瓶颈,实现流量和转化的双重飞跃。希望我的分享对你解决网站收录停滞问题有所启发,也欢迎你随时交流更深入的技术细节与实操经验。

霓优网络科技中心是一家专注于网站搜索引擎优化(SEO)的数字营销服务提供商,致力于帮助企业提升网站在搜索引擎中的排名与收录效果。我们提供全方位的SEO优化服务,包括关键词策略优化、内容质量提升、技术SEO调整及企业数字营销支持,助力客户在竞争激烈的网络环境中获得更高的曝光度和精准流量。