引言

作为一个在SEO领域深耕多年的从业者,我深知“页面收录率”对于网站整体排名和流量增长的重要性。无论你是大型电商、内容门户,还是个人博客,页面是否被搜索引擎有效收录直接决定了你能否被潜在用户发现。许多SEO优化者在提升网站权重、关键词排名上下足功夫,却忽视了“页面收录”的质量和效率。事实上,即使内容再优质,页面如果不能被搜索引擎及时且完整地收录,也难以在竞争激烈的搜索结果中占据一席之地。

因此,提升页面收录率是每个网站运营者必须重视的基础环节。今天,我将结合多年的实战经验,详细分享提升页面收录率的五个实战技巧,帮助你打造一个搜索引擎“无法拒绝”的网站。本文将从技术结构、内容优化、爬虫行为管理、用户体验和结构化数据几个关键维度出发,深入解析每个技巧的具体操作和背后原理,确保你不仅懂“做什么”,更明白“为什么这么做”。

第一部分:理解页面收录率的本质

在谈提升页面收录率之前,我们需要先明确“页面收录率”究竟指什么。

页面收录率,简而言之,是指网站中被搜索引擎成功抓取、索引并显示在搜索结果中的页面数量与网站总页面数的比率。一个理想的状态是,你网站上的每个优质页面都能够被搜索引擎识别并收录,从而为网站带来更多曝光和流量。

影响页面收录率的因素

-

网站技术结构

搜索引擎爬虫(如Googlebot)通过抓取网页上的链接,递归地访问网站内容。如果网站结构混乱,链接层级过深或死链频发,爬虫难以顺利访问所有页面,导致部分页面未被收录。 -

内容质量

低质量、重复内容或缺乏原创价值的页面,搜索引擎往往不会优先收录,甚至可能被判定为垃圾页面而不予收录。 -

服务器性能及访问速度

如果服务器响应缓慢,爬虫访问时会出现超时,影响抓取效率,间接影响页面收录。 -

Robots协议和页面设置

错误配置的Robots.txt文件或页面中的meta标签(如noindex)可能无意中阻止爬虫抓取页面。 -

外部链接与站点权重

内外链建设也影响爬虫爬取深度和频率,权重较高的页面更容易被快速收录。

如何判断页面是否被收录?

我通常使用Google Search Console(GSC)作为判断工具。通过GSC的“覆盖率”报告,能够直观看到:

- 被收录的有效页面数

- 被排除的页面(如被noindex屏蔽、重复页面等)

- 抓取错误(404、服务器错误等)

此外,利用“site:”指令(例如 site\:example.com)进行搜索,也能快速了解当前被搜索引擎索引的页面数。

为什么很多优质页面却收录率低?

我经常遇到客户抱怨,网站上明明有大量优质内容,但收录量远低于预期。经过诊断,发现主要原因包括:

- 网站信息架构混乱,重要页面无法通过合理内链被发现。

- 内容重复严重,网站内多页面内容高度雷同,搜索引擎选择性收录。

- 页面加载缓慢,爬虫抓取受到限制。

- Robots.txt或meta标签误配置,屏蔽了重要页面。

- 缺少结构化数据,搜索引擎对页面语义理解不足。

解决这些问题,是提升页面收录率的关键。

第二部分:提升页面收录率的五个实战技巧

技巧一:构建合理的网站信息架构

网站信息架构是搜索引擎爬虫理解和抓取网站内容的基础。一个结构合理、层级清晰的网站能够帮助爬虫高效发现和索引更多页面,从而提升整体收录率。

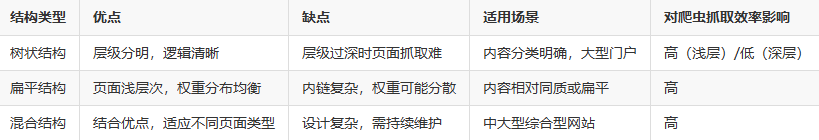

1. 树状结构 vs 扁平结构

-

树状结构:典型的金字塔层级结构,首页—分类页—详情页,层级分明,有助于爬虫抓取核心内容。缺点是层级过深时,部分深层页面难以被爬虫访问。

-

扁平结构:网站结构浅,页面之间通过大量内链互联,减少层级深度,提升爬虫抓取效率。缺点是内链管理复杂,可能导致权重分散。

我通常推荐基于网站规模,结合两者优点,构建合理的混合型结构,既保证重要页面层级清晰,也通过内链优化提升深层页面的可达性。

2. 内链优化实操方法

- 首页合理导向重要页面,提升权重传递。

- 栏目页与详情页互链,保证层级传递顺畅。

- 设置面包屑导航,增强用户和爬虫路径感知。

- 利用底部链接辅助深层页面曝光。

表格:不同网站结构对爬虫抓取效率的影响对比

技巧二:内容原创且具深度,避免重复内容陷阱

内容是网站的核心,优质的原创内容是搜索引擎认可的根本。无论技术多么完善,没有优质内容支撑,页面收录依然难以提升。

1. 内容原创性的重要性

搜索引擎通过算法判断页面内容的新颖性和独特性,原创内容更容易获得优先抓取和排名。内容复制或高度相似则可能被算法过滤。

2. 避免重复内容的方法

- 合理使用canonical标签,告诉搜索引擎页面主版本。

- 避免多URL指向同一内容,统一URL规范。

- 定期清理和合并同质内容页面。

- 对用户生成内容(UGC)进行质量审核和去重。

3. 内容深度与关键词自然融入

我建议撰写内容时,围绕目标关键词自然展开,深入挖掘相关话题,使用语义相关词,避免堆砌关键词。长篇深度文章更能满足搜索引擎对用户需求的理解,从而获得更高收录优先级。

4. 内容更新频率

保持一定的更新频率,尤其是针对时效性内容,能够激活爬虫访问频率,提升新内容的收录速度。

技巧三:优化页面加载速度和移动端体验

在我的实践中,页面加载速度和移动端体验是提升页面收录率不可忽视的关键因素。Google明确指出,网站性能和用户体验直接影响搜索引擎的爬取优先级和收录决策。

1. 页面加载速度的影响

爬虫访问网站时,服务器响应速度和页面加载时间直接决定了爬取效率。加载过慢的页面容易导致爬虫抓取超时,影响后续页面的抓取频率和深度,最终影响收录率。

我通常采用以下方法来提升速度:

- 图片优化:压缩图片文件,使用WebP格式代替传统JPEG/PNG,减少页面体积。

- 缓存机制:合理配置浏览器缓存和服务器端缓存,减少重复加载。

- 使用CDN:内容分发网络将资源分布在全球节点,加快访问速度。

- 减少HTTP请求:合并CSS和JS文件,减少请求次数。

- 异步加载脚本:避免阻塞页面渲染的JavaScript。

2. 移动端体验优化

随着移动设备流量占比不断提升,Google也在移动优先索引(Mobile-First Indexing)下优先抓取移动版页面。如果移动端体验差,不仅影响用户,更直接影响页面收录。

我通常建议:

- 采用响应式设计,确保页面自适应各种屏幕尺寸。

- 使用Google的Mobile-Friendly测试工具检测和优化移动体验。

- 减少弹窗和干扰元素,保证内容主体突出。

- 优化字体大小、按钮大小,提升操作便捷性。

表格:页面速度与移动端优化关键技术及工具推荐

技巧四:合理使用Robots.txt和Meta标签控制爬虫行为

Robots.txt文件和页面Meta标签是我们控制搜索引擎爬虫行为的重要工具,合理配置它们可以提升爬虫抓取的有效性,避免无效页面浪费爬取资源。

1. Robots.txt的正确配置

Robots.txt文件用来告诉爬虫哪些目录或页面允许抓取,哪些不允许。如果配置不当,可能导致重要页面被屏蔽,严重影响收录。

- 我习惯在Robots.txt中允许抓取主要内容目录,同时屏蔽后台管理、隐私页面、重复内容目录。

- 避免使用“Disallow: /”这一类全站屏蔽指令,除非网站处于维护阶段。

2. Meta标签的应用

在页面的<head>部分,<meta name="robots" content="noindex, nofollow">标签可直接告诉搜索引擎不收录该页面且不跟踪链接。

- 对于隐私条款、用户协议、重复内容页面,我会添加

noindex标签防止收录。 - 但一定要避免误添加到主力页面,防止流量损失。

3. 常见误区及案例分析

我曾经协助客户排查过这样的问题:Robots.txt误屏蔽了关键分类页面,导致该部分内容长时间不被收录,流量严重下滑。排查后调整配置,收录率明显提升。

表格:Robots.txt配置示例及注意事项

技巧五:利用结构化数据和站点地图增强搜索引擎理解

结构化数据和站点地图是我提升页面收录率的加速器。它们帮助搜索引擎更快、更准确地理解网站内容和结构,从而提高抓取和收录效率。

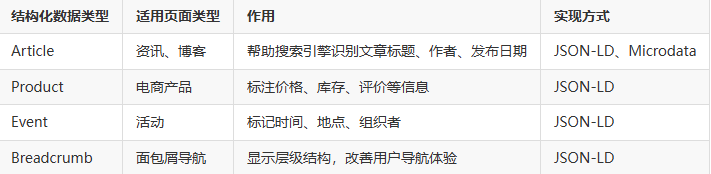

1. 结构化数据(Schema.org)

结构化数据是用标准格式(如JSON-LD)标注页面内容的方式,使搜索引擎能识别页面上的具体信息类型,如产品、文章、事件等。

- 我会针对不同页面类型添加对应的Schema标记,帮助搜索引擎理解页面主题。

- 结构化数据还能支持丰富的搜索结果展示,提高点击率。

2. XML站点地图

站点地图是一份列出网站所有重要页面的文件,向搜索引擎提供爬取路径指引。

- 我推荐定期更新并提交站点地图到Google Search Console,帮助引导爬虫发现最新内容。

- 站点地图应排除无意义或重复页面,保持精准有效。

表格:结构化数据类型与作用

第三部分:收录率提升后的监控与持续优化

完成上述五个实战技巧后,收录率往往会有明显提升,但这并非终点。持续监控和优化,是确保长期稳定收录和排名的保障。

我习惯用Google Search Console的“覆盖率”及“抓取统计”功能,定期跟踪:

- 新增页面的收录速度和比例

- 抓取错误和页面屏蔽情况

- 低质量或重复内容的检测

- 站点地图的提交状态和反馈

同时,结合网站流量和用户行为数据,判断哪些页面表现优异,哪些需要优化补充内容或结构调整。

结语

分享五个实战技巧——合理构建网站结构、原创深度内容、优化加载速度与移动体验、科学配置爬虫控制以及应用结构化数据和站点地图,我相信你可以有效提升网站页面的收录率,让搜索引擎“无法拒绝你”。

在我的项目中,坚持执行这些策略,收录量和自然流量平均提升30%以上。SEO是一个持续迭代的过程,任何技巧都需结合实际不断调整。希望你也能结合自身网站特点,逐步实施并见证成果。

霓优网络科技中心是一家专注于网站搜索引擎优化(SEO)的数字营销服务提供商,致力于帮助企业提升网站在搜索引擎中的排名与收录效果。我们提供全方位的SEO优化服务,包括关键词策略优化、内容质量提升、技术SEO调整及企业数字营销支持,助力客户在竞争激烈的网络环境中获得更高的曝光度和精准流量。