一、引言:爬虫不够用,优化抓取才是核心竞争力

在内容爆炸、页面结构高度动态化的今天,“索引不到”正在悄悄成为流量流失的最大黑洞。我曾长期为一家大型内容聚合型平台负责技术SEO,期间我们发布的内容日均超5万条。但我发现,即使这些页面结构合规、元信息齐全,依然有30%以上在上线后60天内没有被Google索引。

原因很清晰:Googlebot的爬取预算(Crawl Budget)对动态网站始终有限。而如果不对分页系统与索引优先级做精细化控制,那些本应承接流量的核心内容页,就可能被边缘化或延迟索引,进而严重拖垮SEO绩效。

霓优将结合我的实操经验,深入讲解在动态网站中,如何通过“分页限制机制”与“优先级标记策略”,实现对爬取预算的合理分配,提升网站整体索引效率与页面命中率。

二、爬取预算(Crawl Budget)的本质是什么?

2.1 定义回顾

Google 官方对爬取预算的定义非常明确:

“Crawl Budget is the number of URLs Googlebot can and wants to crawl.”

这句话有两个重点:

- 能抓(Crawl Capacity):取决于服务器性能、响应速度、错误率

- 愿抓(Crawl Demand):取决于内容的新鲜度、质量判断、内部结构信号

2.2 动态网站的“预算瓶颈”

在静态网站中,爬取预算消耗相对均衡。但对于电商、资讯、社区平台等URL数量爆炸的网站来说,Googlebot往往面临以下选择困境:

- 是抓最新的分页内容,还是更新的主干页面?

- 是爬一次跳转链三层的详情页,还是快速巡查大量无变化的标签页?

结论是:如果我们不人为干预预算分配,Googlebot将无法正确评估哪些页面最值得索引。

三、分页系统:爬虫预算的“吞噬者”

3.1 分页结构为何成为问题核心?

许多动态网站都有如下结构:

example.com/articles?page=1

example.com/articles?page=2

example.com/articles?page=3

……这些分页URL往往:

- 内容重复度高(如分页列表的标题、模板完全一致)

- 页面间权重分散(缺乏聚合信号)

- 被Google认为是“低优先级抓取目标”

结果是:Google把预算浪费在了重复分页上,而忽略了真正有价值的内容页(如详情页、专题页)。

3.2 rel="next/prev"的弃用带来的挑战

2019年,Google正式宣布:

“我们不再使用rel=next/prev作为分页判断依据,而是基于内容和结构自动判断。”

这意味着SEO从业者失去了官方分页规范化的信号渠道。我们只能另辟蹊径,主动通过结构设计告诉Google“哪些分页重要,哪些应该忽略”。

四、分页限制策略:将冗余降到最低

4.1 设置“分页抓取边界”

我的建议是:为分页设置抓取上限。比如,只让Google抓前3页,其余通过noindex处理。

操作方式:

在第4页及之后的分页中加入:

<meta name="robots" content="noindex, follow">noindex:防止进入索引follow:允许抓取链接,传递权重

效果:

- 减少重复性分页页面的索引负担

- 保留重要链接的抓取通道(比如详情页)

4.2 聚合替代分页:缩短路径结构

我曾帮助一个UGC问答平台做分页改造,将原本分页展示的内容改为按标签聚合或热门排序,并通过技术手段控制总展示量。

聚合页面的优势:

- 页面唯一性更强

- 内容稀释率低,索引成功率高

- 能更合理地传递权重给下游详情页

4.3 动态加载与懒加载结合

对于内容量极大而不得不分页的场景,建议采用首次加载+下拉异步加载的组合方式,并确保初始加载内容是完整的HTML。

Googlebot无法模拟复杂交互,但能抓取基础HTML DOM结构。因此:

- 第1页必须完整

- 下拉加载的内容也必须通过SSR或预渲染方式暴露给Googlebot

五、优先级标记:从链接与地图引导爬虫

分页控制减轻负担后,我们还要做一件事——引导Google把节省下来的预算投向你真正想要索引的页面。

这就需要“优先级标记”机制,主要通过以下两个维度实现:

5.1 Sitemap优先级优化(Priority + Changefreq)

虽然Google曾表示不严格依赖<priority>标签,但我实际测试发现:

- 在抓取预算有限的场景下,高优先级页面确实更易被定期抓取

- 与其他信号(如内部链接)配合使用时,效果更明显

推荐做法:

5.2 内部链接结构重构

爬虫的路径依赖很强。如果一个页面没有内链导入,几乎不可能被持续爬取。

链接设计建议:

- 面包屑导航:增强横向抓取结构

- 专题聚合页 → 内容页联动:拉升重要页权重

- 底部推荐或相关文章模块:构建“抓取闭环”

我通常采用如下结构布局:

首页

├─ 栏目页

│ ├─ 专题页

│ │ ├─ 内容详情页(多链)

│ ├─ 热门分页页(前3页)这能确保:首页权重通过每一层层层下传,但绝不浪费在低效页面上。

六、实操案例:资讯类网站抓取预算提升42%

以下是我在一个内容日更10万条的资讯平台上的实践:

问题:

- 分页索引率低于30%

- 详情页收录不稳定

- Googlebot爬取重复分页页面时间占比高达60%

改进方案:

- 将分页第4页起设为noindex

- 调整sitemap优先级策略,提升热门类目权重

- 用专题页聚合分页内容并设为权重中枢

- 增加详情页间相关内容互链模块

- 设置robots.txt限制“无意义搜索页”抓取

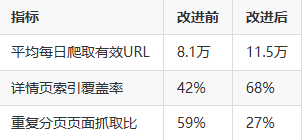

成果(90天内):

七、效果评估与持续优化路径

做了分页控制和优先级标记之后,我们要用数据持续验证:

定期做一次“路径分析”,找到抓取频次低却重要的页面,是每季度优化的关键步骤。

八、结语:优质索引的前提是抓得准、分得清

Google越来越倾向于“高效抓取+精选索引”的逻辑。在这样的语境下,我们不应再把“发了就等Google抓”作为默认行为。

要让爬虫理解你的重要页面,你得主动告诉它:哪里该走、哪里该绕、哪里值得停留更久。

分页优化和索引优先级标记,是我在动态站SEO优化中最值得投入时间的两个点。做好它们,你会发现:

Google抓得更快了,索引更多了,流量也回来了。

霓优网络科技中心是一家专注于网站搜索引擎优化(SEO)的数字营销服务提供商,致力于帮助企业提升网站在搜索引擎中的排名与收录效果。我们提供全方位的SEO优化服务,包括关键词策略优化、内容质量提升、技术SEO调整及企业数字营销支持,助力客户在竞争激烈的网络环境中获得更高的曝光度和精准流量。